◇ 공부 기록용으로 작성하였으니 틀린점, 피드백 주시면 감사하겠습니다 ◇

S3 Transfer Acceleration:

S3로 데이터를 (추가 요금을 내더라도) 더 빠르게 업로드할 수 있도록 하는 기능

Faster long-distance S3 uploads & downloads

S3 Transfer Acceleration

Transfer Acceleration는 CloudFront의 글로벌 엣지 로케이션(Edge Location)을 활용하여 S3 버킷으로 데이터를 더 빠르게 업로드할 수 있도록 하는 기능이다. (최적화된 네트워크 경로를 통해 업로드 속도를 향상시킨다)

👩🏫 고속 업로드가 가능한 이유

사용자와 지리적으로 가까운 엣지 로케이션에서 고성능 AWS 네트워크를 경유해 S3 버킷에 접근하기 때문에 고속 업로드가 가능하다

👩🏫 사용 예시 (Use Case)

- 다른 Region의 S3 버킷에 파일을 전송할 경우

- 대륙간에 정기적으로 GB~TB규모의 데이터를 전송하는 경우

Tokyo Region에서 Seoul Region의 S3 버킷에 데이터를 전송할 경우에 최적화 된 네트워크 경로를 통해 빠르게 전송할 수 있다. (장거리 전송일 경우 데이터를 최대 50 - 500%까지 고속 전송가능)

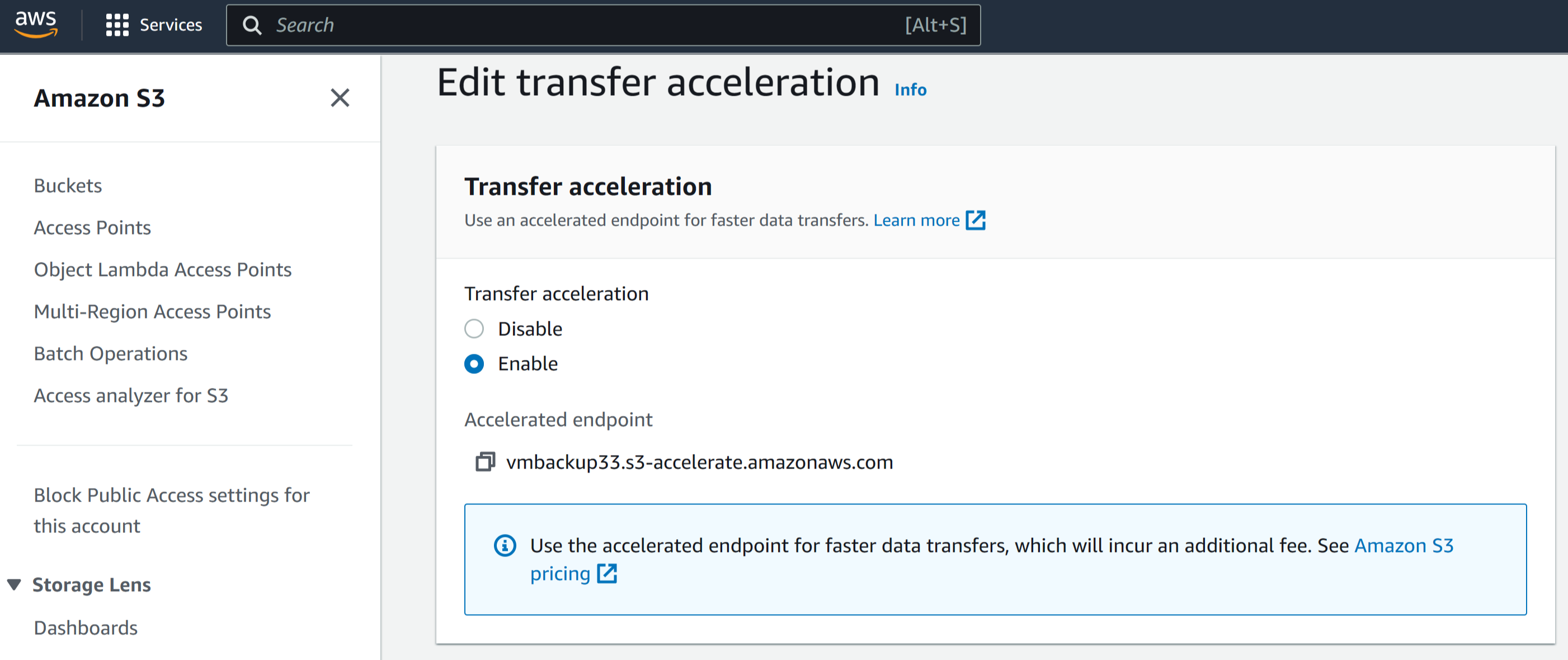

👩🏫 S3 Transfer Acceleration 설정 방법

(엄청 쉽다) AWS S3 → Bucket → Properties → Transfer Acceleration → Enable

업로드 시 가속화된 엔드포인트 사용

기본 S3 엔드포인트: https://BUCKET-NAME.s3.amazonaws.comTransfer Acceleration 엔드포인트: https://BUCKET-NAME.s3-accelerate.amazonaws.com

🤔 SOA 문제

회사는 매일 기가바이트(GB) 단위의 파일을 업로드해야 합니다.

더 높은 처리량(throughput)과 업로드 속도를 달성하여 Amazon S3로 데이터를 더 빠르게 업로드하려고 합니다.

SysOps 관리자는 이 요구사항을 충족하기 위해 어떤 조치를 취해야 할까요?

- Amazon CloudFront 배포를 생성하고, GET HTTP 메서드를 허용하며, S3 버킷을 오리진으로 설정한다.

- Amazon ElastiCache 클러스터를 생성하고, S3 버킷에 대한 캐싱을 활성화한다.

- AWS Global Accelerator를 설정하고, S3 버킷과 구성한다.

- S3 Transfer Acceleration을 활성화하고, 업로드 시 가속화된 엔드포인트를 사용한다.

정답

4번

🤨 SAA 문제

S3의 "Transfer Acceleration" 기능에 대한 설명으로 올바른 것은 무엇인가?

- 데이터를 자동으로 다른 리전에 저장하는 기능

- 데이터를 전용 네트워크를 통해 온프레미스 환경으로 전송하는 기능

- 데이터를 여러 AZ에 고속으로 전송하는 기능

- 사용자로부터 S3 버킷으로 최적화된 네트워크 경로를 통해 데이터를 전송하는 기능

정답 & 오답

정답. 4번

사용자로부터 S3 버킷으로 최적화된 네트워크 경로를 통해 데이터를 전송하는 기능

1번. 데이터를 자동으로 다른 리전에 저장하는 기능

S3의 기능인 "크로스 리전 레플리케이션"에 대한 설명이므로, 틀렸습니다.

2번. 데이터를 전용 네트워크를 통해 온프레미스 환경으로 전송하는 기능

S3의 기능이 아닌 "AWS Direct Connect" 서비스이므로, 틀렸습니다.

3번. 데이터를 여러 AZ에 고속으로 전송하는 기능

S3에 저장된 데이터는 S3 One Zone-IA 스토리지 클래스를 제외하고 자동으로 여러 AZ로 복사되지만, 고속 전송하는 기능은 없으므로, 틀렸습니다.

🤨 SAA 문제

회사는 여러 대륙의 도시에서 온도, 습도, 대기압 데이터를 수집하고 있습니다. 각 사이트에서 매일 평균 500GB의 데이터를 수집하며, 고속 인터넷 연결을 사용하고 있습니다. 회사는 전 세계 모든 사이트의 데이터를 가능한 한 빨리 하나의 Amazon S3 버킷에 집계하려고 합니다. 이 솔루션은 운영 복잡성을 최소화해야 합니다.

어떤 솔루션이 이러한 요구사항을 충족할까요?

- S3 Transfer Acceleration을 활성화하고, 멀티파트 업로드를 사용하여 각 사이트에서 데이터를 직접 S3로 업로드한다.

- 각 사이트에서 가장 가까운 AWS 리전의 S3 버킷으로 데이터를 업로드하고, S3 크로스 리전 복제를 사용하여 대상 S3 버킷으로 데이터를 복사한 후 원본 데이터를 삭제한다.

- 매일 AWS Snowball Edge Storage Optimized 기기를 사용하여 데이터를 가장 가까운 AWS 리전으로 전송하고, S3 크로스 리전 복제를 사용하여 대상 S3 버킷으로 데이터를 복사한다.

- 각 사이트에서 가장 가까운 AWS 리전의 EC2 인스턴스로 데이터를 업로드하고, Amazon EBS 볼륨에 저장한다. 정기적으로 EBS 스냅샷을 생성하여 대상 S3 버킷이 있는 리전으로 복사한 후, 해당 리전에서 EBS 볼륨을 복원한다.

정답

정답. 1